Сайт дня (как попасть): Научим получать одноцентовый тематический трафик с Яндекс.Директ.

Дорогие друзья, сегодня я хочу поделиться с вами своими мыслями по поводу нового поискового алгоритма Google Penguin.

На мой взгляд, впервые новый алгоритм Google активно себя проявил в рунете. До этого, по большому счету, алгоритмы Гугла нас практически не касались, зато в англоязычном сегменте интернета многие вебмастера и оптимизаторы ощущали эффект в полной мере.

О чем это говорит? О том, что продвижение в Google становится более сложным. До недавнего времени считалось, что вывести сайт в топ 10 этого поисковика намного легче, чем сделать это в Яндексе.

Я еще думаю, что раньше алгоритмы Google в рунете не были задействованы в полной мере потому, что наш рынок не представлял особого интереса для этой поисковой системы. Сейчас ситуация меняется.

Сегодня рунет - самый крупный и быстрорастущий рынок в Европе по количеству интернет пользователей. Во многом это обусловлено ростом числа пользователей в регионах и увеличения доли мобильного интернета (за счет удешевления тарифов).

Хватит скучных вступлений! Я чувствую эту мысль в головах владельцев сайтов, которые пострадали от последнего алгоритма Google Penguin 🙂 . Для успокоения 🙂 советую посмотреть это видео Мэтта Каттса, сотрудника Google, с моими переводом - Как быстро Google снимает фильтры с сайта.

На просторах интернета уже есть довольно много статей по поводу того, как вывести сайт на прежние позиции, если он пострадал от Пингвина.

Я не стал спешить с выводами и все это время наблюдал за ситуацией и изучал причины, по которым посещаемость и позиции сайтов могли понизиться. На нескольких сайтах я применил методы, которые, на мой взгляд, могли помочь исправить ситуацию.

В сегодняшнем посте я хочу поделиться с вами некоторыми выводами, которые я сделал, изучая сайты, пострадавшие и не пострадавшие от алгоритма Гугл Пингвин.

В одной из следующих статей я опишу те методы, которые дали эффект в плане восстановления позиций и посещаемости.

Вот мои предварительные выводы.

🔥 Кстати! Я провожу платный курс по продвижению англоязычных сайтов SEO Шаолинь seoshaolin.com. Для читателей блога я делаю хорошую скидку. По прокомоду "блог" тариф Про стоит не 50, а 40 тыс. рублей. Тариф Лайт не 25, а 20 тыс. рублей. Тариф Команда не 75, а 60 тыс. рублей. Пишите мне в Telegram @mikeshakin.Сайты с посещаемостью более 500-1000 человек в сутки менее подвержены воздействию Google Penguin

Изучая пострадавшие сайты, я выявил закономерность - ресурсы с суточной посещаемостью в 500-1000 и более человек почти не испытали на себе негативного воздействия нового алгоритма Гугла.

С одной стороны, получается замкнутый круг - как увеличить посещаемость, когда она упала вместе с позициями?

С другой, по низко- и среднечастотным запросам вполне можно наращивать количество посетителей. Основной метод для этого - публикация больших о объемных материалов. Раздел статей или блог можно вести на ресурсе любого типа - интернет-магазине, корпоративном сайте, сообществе, новостном сайте, сайте-визитке и т.д.

Google Пингвин перестал учитывать часть внешних ссылок

Я пришел к выводу, что одним из проявлений нового алгоритма стало то, что часть внешних ссылок на сайты перестала учитываться. Это привело к падению посещаемости и позиций у некоторых ресурсов.

На мой взгляд, в первую очередь потеряли свою эффективность некоторые покупные ссылки и ссылки с сайтов, на которые пользователи могут добавить ссылки без предварительной модерации (заспамленные и заброшенные блоги и форумы).

Возможно, стали эффективнее определяться покупные ссылки (я как-то писал пост на эту тему - 7 признаков покупных ссылок).

Но, скорее всего, вычисление покупных ссылок для Google всегда не было проблемой, просто сейчас он перешел к кардинальным действиям по борьбе с ними, и часть из них перестала влиять на результаты поиска.

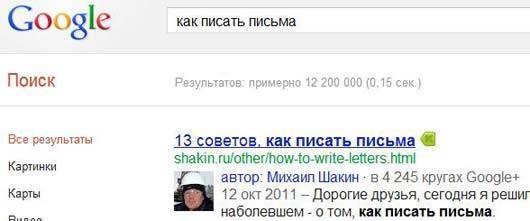

Авторство в Google+ снижает риск

Я заметил, что сайты, у которых подтверждено авторство в Google+ (то есть в результатах поиска выводится фото автора), менее подвержены риску.

Приведу скриншот результатов выдачи с расширенным описанием блога shakin.ru и фотографией. Там я в модной каске и стильных очках на нефтяном месторождении под Сургутом 😉 :

Думаю, причина тут проста и логична - авторство владельцы сайтов будут подтверждать только для тех своих ресурсов, которыми активно занимаются. Для второстепенных и заброшенных сайтов никто этого делать не будет.

Вот отличная инструкция, как подтвердить авторство - Как сделать расширенный сниппет с фотографией в Google+.

Сайты с числом страниц менее 20-30 более подвержены воздействию Google Пингвина

Просмотрев сотни сайтов, я заметил еще одну особенность - у сайтов с небольшим количеством страниц больше риск пострадать от алгоритма.

Ресурсов с сотнями и тысячами страниц намного меньше среди тех, у которых понизились позиции и посещаемость.

Сайты, которые давно не обновлялись, чаще подвержены риску

Это еще один вывод, который я сделал. В этом есть логика. Если сайт регулярно обновляется, то можно считать, что его владелец заботится о нем и развивает.

Если обновлений на сайте нет долгие месяцы и годы - он мало кому интересен.

Сайты с хорошими поведенческими факторами пострадали меньше

Основные поведенческие факторы - это количество просмотров страниц на посетителя и время нахождения пользователей на сайте. Чем больше страниц просматривают на вашем сайте и чем дольше время, в течение которого посетители находятся на Вашем ресурсе, тем лучше поведенческие.

Ресурсы с хорошими поведенческими факторами, на мой взгляд, в меньшей степени пострадали от Google Penguin.

Контентные сайты с большими по размеру текстами пострадали в меньшей степени

Ресурсы, которые публикуют объемные статьи (от 4000-6000 символов), пострадали намного меньше, чем сайты с небольшими по размеру текстами.

На мой взгляд, это хорошо. Чем больше статья, тем больше вероятность, что владелец заботится о развитии и наполнении своего сайта.

Естественно, я веду речь об уникальном контенте.

Сквозные ссылки как работали, так и продолжают работать

Сквозные ссылки, то есть ссылки со всех страниц сайтов, продолжают давать хороший эффект при продвижении в Google.

Думаю, одна из причин того, что их эффективность не понизилась при Пингвине, заключается в том, что такие ссылки нельзя купить на сервисах и биржах. Их можно купить, только договорившись напрямую с владельцем сайта либо в соответствующих разделах на форумах.

Какие факторы не влияют

1. Плотность поисковых запросов в тексте и метатегах - судя по сегодняшним топам в разных тематиках, хорошие позиции могут занимать сайты с самой разной плотностью ключевых слов.

2. Дубли страниц - я думаю, что сайты, на которых дублированный контент не закрыт специально от индексации, вполне могут продолжать занимать топы Google. Большинство современных движков сайтов генерируют определенное количество дублированного контента в пределах сайта, и поисковые системы об этом прекрасно знают.

Окончательные выводы делать рано

Я уверен, что новый алгоритм Google Пингвин будет постоянно дорабатываться и совершенствоваться, и кое-какие моменты могут измениться или появятся новые.

Поэтому подводить итоги я не буду, чего и вам желаю! Изучайте, наблюдайте и экспериментируйте, и все обязательно получится!

Кстати, а у вас какие выводы?

Постовой (как попасть): Хотите знать о SEO больше, чем другие? Тогда читайте блог сеошника.

Десерт на сегодня - нереальный танец японца, зал просто визжит от восторга, недаром у ролика почти три миллиона просмотров 😉

Подпишитесь на рассылку блога с полезными материалами по SEO

Меня зовут Михаил Шакин, я автор этого блога, занимаюсь SEO с 2006 года. Вы можете заказать у меня

Меня зовут Михаил Шакин, я автор этого блога, занимаюсь SEO с 2006 года. Вы можете заказать у меня

Всё таки прочитал пост.

Гугл Пингвин не зря многие называют Google Dance - так как это действительно похоже на танцы с бубном)

Есть сайт - возраст 2,5 года

В индексе 2500 страниц

Показатель возвратов ~25%

Просмотры -

1 просмотр - 67 процентов

2-3 - 7%

4-20 ~ 25

и так далее

1 минута просмотра - 60%

2 минуты - 11

До 10 - 24

и так далее

Обновляется сайт каждый день по 2 новости

Единственное что хромает - контент, он уникальный, но не Лев Толстой 🙂 (девочка сидит переводит)

Посещалка до Пингвина - ~3к, сейчас - 1к

Хотя по твоей логике должен был остаться в норме...

Да, я еще пока не знала о Google Penguin. Спасибо, что проинформировали!